💬 Инструменты обнаружения ИИ не могут обнаружить мошенников от 2023-07-22

👑 Premium-робот: получай более 20-ти торговых идей в день!

👑 Premium-робот: получай более 20-ти торговых идей в день!

Инструменты обнаружения ИИ не могут обнаружить мошенников

Сложные достижения искусственного интеллекта привели к появлению больших языковых моделей (LLM), таких как ChatGPT и Google Bard. Эти объекты могут генерировать контент, настолько похожий на человеческий, что это бросает вызов концепции подлинности.

В то время как преподаватели и создатели контента сплачиваются, чтобы подчеркнуть потенциальное неправомерное использование LLM, от мошенничества до обмана, программное обеспечение для обнаружения ИИ утверждает, что у него есть противоядие. Но насколько надежны эти программные решения?

Ненадежное программное обеспечение для обнаружения ИИ

Многим инструменты обнаружения ИИ дают проблеск надежды против эрозии правды. Они обещают выявить искусственность, сохранив святость человеческого творчества.

Однако компьютерщики из Мэрилендского университета проверили это утверждение в поисках достоверности. Результаты? Трезвый тревожный сигнал для отрасли.

Сохейл Фейзи, доцент UMD, раскрыл уязвимости этих детекторов ИИ, заявив, что они ненадежны в практических сценариях. Простое перефразирование контента, сгенерированного LLM, часто может ввести в заблуждение методы обнаружения, используемые Check For AI, Compilatio, Content at Scale, Crossplag, DetectGPT, Go Winston и GPT Zero, и это лишь некоторые из них.

«Точность даже самого лучшего детектора, который у нас есть, падает со 100% до случайности подбрасывания монеты. Если мы просто перефразируем то, что было сгенерировано LLM, мы часто можем перехитрить ряд методов обнаружения», — сказал Фейзи.

«Точность даже самого лучшего детектора, который у нас есть, падает со 100% до случайности подбрасывания монеты. Если мы просто перефразируем то, что было сгенерировано LLM, мы часто можем перехитрить ряд методов обнаружения», — сказал Фейзи.

Это осознание, утверждает Фейзи, подчеркивает ненадежную дихотомию ошибок типа I, когда человеческий текст ошибочно помечается как сгенерированный ИИ, и ошибок типа II, когда контенту ИИ удается проскользнуть через сеть незамеченным.

Один примечательный случай попал в заголовки газет, когда программное обеспечение для обнаружения ИИ ошибочно классифицировало Конституцию Соединенных Штатов как созданную ИИ. Ошибки такого масштаба — это не только технические заминки, но и потенциальный ущерб для репутации, приводящий к серьезным социально-этическим последствиям.

Фейзи также освещает затруднительное положение, предполагая, что различие между контентом, созданным человеком и контентом, созданным ИИ, вскоре может стать сложной задачей из-за эволюции LLM.

«Теоретически вы никогда не сможете с уверенностью сказать, что это предложение было написано человеком или каким-то искусственным интеллектом, потому что распределение между двумя типами контента очень близко друг к другу. Это особенно верно, когда вы думаете о том, насколько изощренными становятся LLM и злоумышленники LLM, такие как перефразирование или спуфинг», — сказал Фейзи.

«Теоретически вы никогда не сможете с уверенностью сказать, что это предложение было написано человеком или каким-то искусственным интеллектом, потому что распределение между двумя типами контента очень близко друг к другу. Это особенно верно, когда вы думаете о том, насколько изощренными становятся LLM и злоумышленники LLM, такие как перефразирование или спуфинг», — сказал Фейзи.

Выявление уникальных человеческих качеств

Однако, как и в любом научном дискурсе, существует контрнарратив. Доцент UMD по компьютерным наукам Фуронг Хуанг придерживается более радужной точки зрения.

Она постулирует, что при наличии достаточного количества данных, показывающих, что представляет собой человеческое содержание, различение между ними все же может быть достижимо. По мере того как LLM оттачивают свою имитацию, питаясь обширными текстовыми репозиториями, Хуанг считает, что инструменты обнаружения могут развиваться, если им будет предоставлен доступ к более обширным обучающим образцам.

Команда Хуанга также сосредотачивается на уникальном человеческом факторе, который может быть спасительной благодатью. Врожденное разнообразие в человеческом поведении, охватывающее уникальные грамматические причуды и выбор слов, может быть ключом.

«Это будет похоже на постоянную гонку вооружений между генеративным ИИ и детекторами. Но мы надеемся, что эти динамические отношения действительно улучшат наш подход к созданию как генеративных LLM, так и их детекторов в первую очередь», — сказал Хуанг.

«Это будет похоже на постоянную гонку вооружений между генеративным ИИ и детекторами. Но мы надеемся, что эти динамические отношения действительно улучшат наш подход к созданию как генеративных LLM, так и их детекторов в первую очередь», — сказал Хуанг.

Споры вокруг эффективности обнаружения ИИ — лишь один из аспектов более широких дебатов об ИИ. Фейзи и Хуан согласны с тем, что прямой запрет таких инструментов, как ChatGPT, не является решением проблемы. Эти LLM обладают огромным потенциалом для таких секторов, как образование.

Вместо того, чтобы стремиться к невероятной, на 100% надежной системе, акцент должен быть сделан на защите существующих систем от известных уязвимостей.

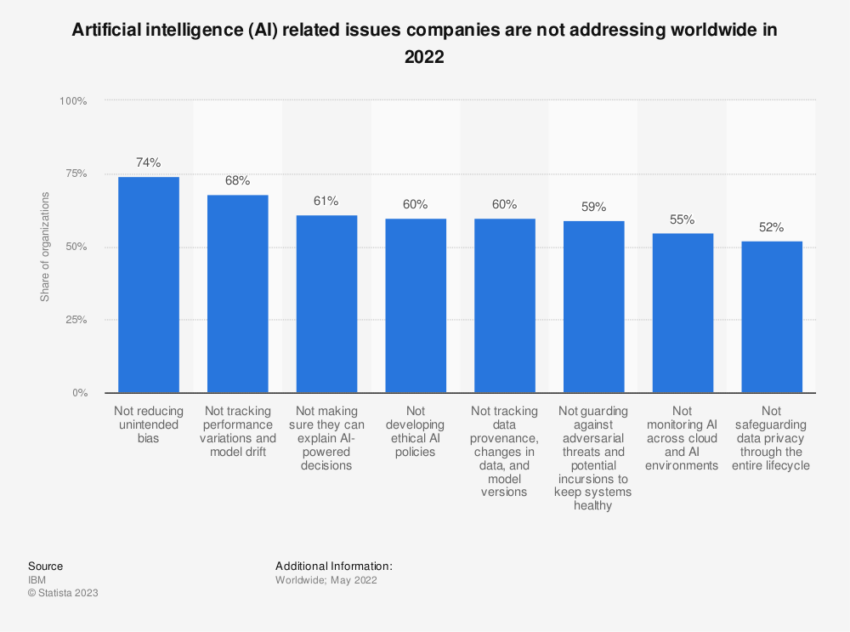

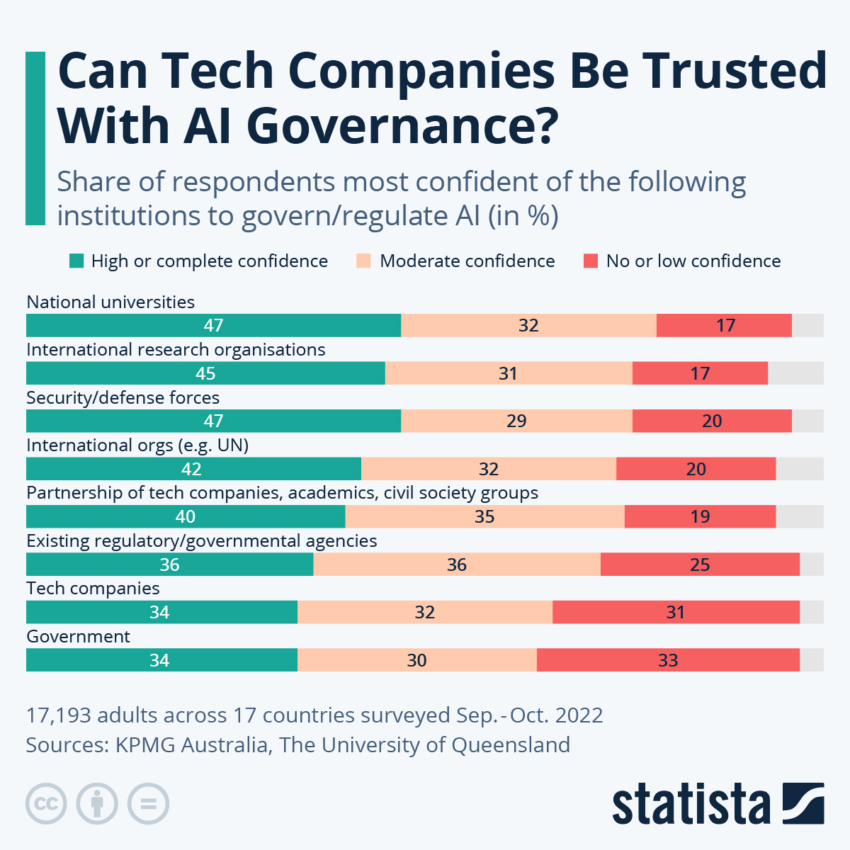

Растущая потребность в регулировании ИИ

Будущие меры безопасности могут основываться не только на текстовом анализе. Фейзи намекает на интеграцию инструментов вторичной проверки, таких как аутентификация по номеру телефона, связанная с отправкой контента, или анализ поведенческих моделей.

Эти дополнительные уровни могут улучшить защиту от ложного обнаружения ИИ и врожденных предубеждений.

В то время как ИИ может быть покрыт неопределенностями, Фейзи и Хуанг подчеркивают необходимость открытого диалога об этичном использовании LLM. Существует коллективный консенсус в отношении того, что эти инструменты при ответственном использовании могут принести значительную пользу обществу, особенно в сфере образования и противодействия дезинформации.

Однако предстоящее путешествие не лишено трудностей. Хуан подчеркивает важность установления основополагающих правил посредством обсуждений с политиками.

Хуанг утверждает, что подход «сверху вниз» имеет решающее значение для обеспечения согласованной структуры, регулирующей LLM, поскольку исследовательское сообщество неустанно ищет более совершенные детекторы и водяные знаки для пресечения злоупотреблений ИИ.

Ограничение / снятие ответственности (дисклеймер): Вся информация на этом сайте предоставляется исключительно в информационных целях и не является предложением или рекомендацией к покупке, продаже или удержанию каких-либо ценных бумаг, акций или других финансовых инструментов. Авторы контента не несут ответственности за действия пользователей, основанные на предоставленной информации. Пользователи обязаны самостоятельно оценивать риски и проконсультироваться со специалистами перед принятием каких-либо инвестиционных решений. Вся информация на сайте может быть изменена без предварительного уведомления.

Свежие новости по теме: Криптовалюта, NFT и криптобиржи

-

Криптовалюта и NFT

Долгосрочные держатели продают биткойны на 43 миллиарда долларов, но быки не беспокоятся

2025-11-19 просмотры: 126 -

Криптовалюта и NFT

ZEC продолжает ралли, даже несмотря на снижение цены BTC

2025-11-19 просмотры: 402 -

Криптовалюта и NFT

Биткойн близок к самому низкому уровню с июня, поскольку приостановка работы правительства США стала самой продолжительной

2025-11-19 просмотры: 188 -

Криптовалюта и NFT

Крипто-крах сегодня: почему биткойны и альткойны сильно падают?

2025-11-19 просмотры: 415 -

Криптовалюта и NFT

Намерения NEAR стирают грань между тем, чего могут достичь люди и искусственный интеллект

2025-11-19 просмотры: 273 -

Криптовалюта и NFT

Китай печатает деньги быстрее, чем США, и Биткойну нравится этот путь

2025-11-19 просмотры: 171 -

Криптовалюта и NFT

Одно болезненное падение перед следующим ралли цен на биткойны? Вот что показывают графики

2025-11-19 просмотры: 211 -

Криптовалюта и NFT

Прогноз цен на DASH: DASH выросла на 200% после того, как листинг Aster повысил доверие рынка

2025-11-19 просмотры: 371 -

Криптовалюта и NFT

Экосистема XRP нагревается из-за регистрации ETF в оттенках серого и новых планов токенизации

2025-11-19 просмотры: 287