💬 Все чат-боты, такие как ChatGPT и Google Bard, не соответствуют стандартам ЕС в области ИИ: исследование от 2023-06-21

👑 Premium-робот: получай более 20-ти торговых идей в день!

👑 Premium-робот: получай более 20-ти торговых идей в день!

Все чат-боты, такие как ChatGPT и Google Bard, не соответствуют стандартам ЕС в области ИИ: исследование

Исследователи из Стэнфордского университета недавно пришли к выводу, что ни одна из современных больших языковых моделей (LLM), используемых в инструментах искусственного интеллекта, таких как GPT-4 от OpenAI и Bard от Google, не соответствует Закону Европейского Союза (ЕС) об искусственном интеллекте (ИИ).

Закон, первый в своем роде, регулирующий ИИ на национальном и региональном уровнях, был только что принят Европейским парламентом. Закон ЕС об ИИ регулирует ИИ не только в ЕС, охватывающем 450 миллионов человек, но и служит новаторским планом для мировых правил ИИ.

Но, согласно последнему исследованию Стэнфорда, компаниям, работающим с искусственным интеллектом, предстоит пройти долгий путь, если они намерены добиться соответствия.

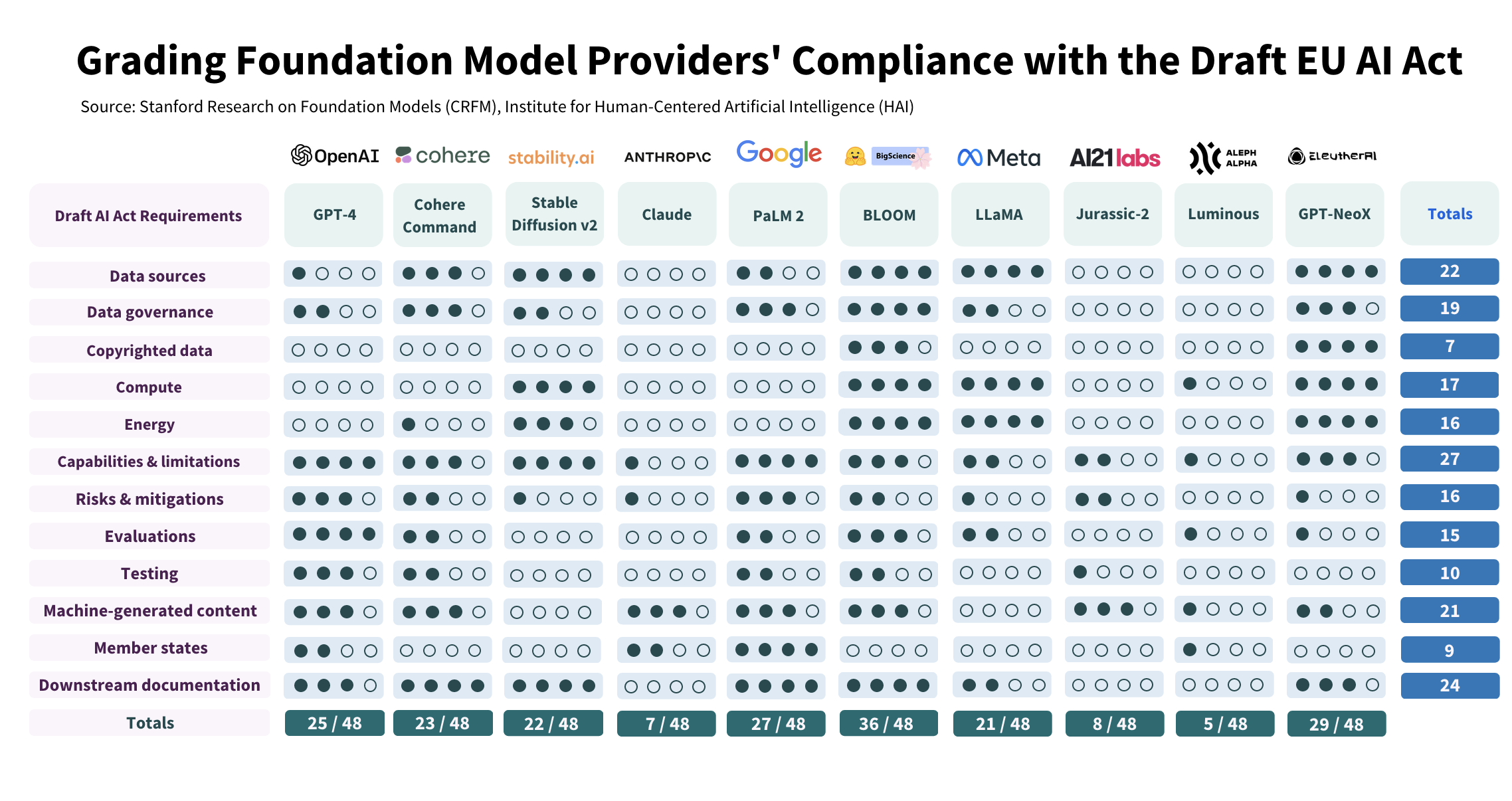

В своем исследовании исследователи оценили десять основных поставщиков моделей. Они оценили степень соответствия каждого поставщика 12 требованиям, изложенным в Законе об искусственном интеллекте, по шкале от 0 до 4.

Исследование выявило большое расхождение в уровнях соответствия: некоторые поставщики набрали менее 25% за соответствие требованиям Закона об искусственном интеллекте, и только один поставщик, Hugging Face/BigScience, набрал более 75%.

Ясно, что даже у поставщиков с высокими баллами есть возможности для значительного улучшения.

Исследование проливает свет на некоторые важные моменты несоблюдения. Исследователи написали, что отсутствие прозрачности в раскрытии статуса защищенных авторским правом данных о тренировках, используемой энергии, производимых выбросах и методологии снижения потенциальных рисков были одними из самых тревожных выводов.

Кроме того, команда обнаружила явное несоответствие между открытыми и закрытыми выпусками моделей, при этом открытые выпуски ведут к более надежному раскрытию ресурсов, но сопряжены с большими трудностями при мониторинге или управлении развертыванием.

Стэнфорд пришел к выводу, что все провайдеры могут реально улучшить свое поведение, независимо от их стратегии выпуска.

В последние месяцы произошло заметное снижение прозрачности выпусков основных моделей. OpenAI, например, не раскрывает данные и вычисления в своих отчетах для GPT-4, ссылаясь на конкурентную среду и последствия для безопасности.

Европейские правила искусственного интеллекта могут изменить отрасль

Хотя эти выводы важны, они также соответствуют более широкому развивающемуся нарративу. В последнее время OpenAI лоббирует, чтобы повлиять на позицию различных стран в отношении ИИ. Технический гигант даже пригрозил покинуть Европу, если правила будут слишком строгими — позже он отказался от этой угрозы. Такие действия подчеркивают сложные и часто напряженные отношения между поставщиками технологий ИИ и регулирующими органами.

Исследователи предложили несколько рекомендаций по улучшению регулирования ИИ. Для политиков ЕС это включает в себя обеспечение того, чтобы Закон об ИИ требовал от крупных поставщиков базовых моделей ответственности за прозрачность и подотчетность. Также подчеркивается потребность в технических ресурсах и талантах для обеспечения соблюдения Закона, что отражает сложность экосистемы ИИ.

По словам исследователей, основная проблема заключается в том, насколько быстро поставщики моделей смогут адаптировать и развивать свои методы ведения бизнеса в соответствии с нормативными требованиями. Они заметили, что без сильного регулирующего давления многие поставщики услуг могли бы получить общие баллы от 30 до 40 (из 48 возможных) за счет значимых, но правдоподобных изменений.

Работа исследователей предлагает проницательный взгляд на будущее регулирования ИИ. Они утверждают, что, если закон об ИИ будет принят и введен в действие, он окажет значительное положительное влияние на экосистему, проложив путь к большей прозрачности и подотчетности.

ИИ меняет общество благодаря своим беспрецедентным возможностям и рискам. Поскольку мир стоит на пороге регулирования этой технологии, меняющей правила игры, становится все более очевидным, что прозрачность — это не просто необязательная надстройка — это краеугольный камень ответственного развертывания ИИ.

Ограничение / снятие ответственности (дисклеймер): Вся информация на этом сайте предоставляется исключительно в информационных целях и не является предложением или рекомендацией к покупке, продаже или удержанию каких-либо ценных бумаг, акций или других финансовых инструментов. Авторы контента не несут ответственности за действия пользователей, основанные на предоставленной информации. Пользователи обязаны самостоятельно оценивать риски и проконсультироваться со специалистами перед принятием каких-либо инвестиционных решений. Вся информация на сайте может быть изменена без предварительного уведомления.

Свежие новости по теме: Криптовалюта, NFT и криптобиржи

-

Криптовалюта и NFT

Сообщество Pi Network извлекает уроки из биткойн-кита стоимостью 1 миллиард долларов

2025-11-20 просмотры: 164 -

Криптовалюта и NFT

ETF на биткойны и эфиры истекают кровью, поскольку Солана незаметно привлекает «любопытный капитал»

2025-11-20 просмотры: 152 -

Криптовалюта и NFT

Накопительный вывод средств: обновление на 1–2 дня для ускорения внедрения уровня 2

2025-11-20 просмотры: 166 -

Криптовалюта и NFT

Доминирование USDT преодолевает ключевое сопротивление: поворотный момент для биткойнов и альткойнов

2025-11-20 просмотры: 122 -

Криптовалюта и NFT

Умный трейдер настроен оптимистично в отношении биткойнов, Ethereum и Solana

2025-11-20 просмотры: 282 -

Криптовалюта и NFT

Корпоративный кит, который всегда покупал биткойны (BTC), внезапно передумал и начал продавать! – Киты Эфириума бросают вызов падению и покупают 1 доллар…

2025-11-20 просмотры: 404 -

Криптовалюта и NFT

Прогноз цен Dogecoin. Продавцы переворачивают EMA в сопротивление в качестве цели пробоя $0,13

2025-11-20 просмотры: 271 -

Криптовалюта и NFT

Киты ETH покупают падение, поскольку Ethereum снова достигает $3000: куда движутся цены?

2025-11-20 просмотры: 135 -

Криптовалюта и NFT

Прогноз цен на Ethereum: потеря основной линии тренда и целевые показатели ликвидности смещаются к $3000

2025-11-20 просмотры: 185