💬 Запустить собственную локальную модель искусственного интеллекта с открытым исходным кодом легко — вот как от 2025-12-04

👑 Premium-робот: получай более 20-ти торговых идей в день!

👑 Premium-робот: получай более 20-ти торговых идей в день!

Запустить собственную локальную модель искусственного интеллекта с открытым исходным кодом легко — вот как

>>>> Предупреждение gd2md-html: встроенная ссылка на изображение в сгенерированном исходном коде и сохранение изображений на вашем сервере. ПРИМЕЧАНИЕ. Изображения в экспортированном zip-файле из Документов Google могут отображаться не в том же порядке, что и в вашем документе. Пожалуйста, проверьте изображения!

Если вы не разработчик, то зачем вам запускать модель искусственного интеллекта с открытым исходным кодом на своем домашнем компьютере?

Оказывается, есть ряд веских причин. А поскольку бесплатные модели с открытым исходным кодом становятся лучше, чем когда-либо, и просты в использовании, с минимальными требованиями к оборудованию, сейчас самое время попробовать.

Вот несколько причин, почему модели с открытым исходным кодом лучше, чем платить 20 долларов в месяц за ChatGPT, Perplexity или Google:

Входной барьер рухнул. Сейчас существуют специализированные программы, которые позволяют пользователям экспериментировать с ИИ без необходимости самостоятельной установки библиотек, зависимостей и плагинов. Это может сделать практически любой, у кого есть достаточно новый компьютер: ноутбук или настольный компьютер среднего класса с 8 ГБ видеопамяти может работать с удивительно функциональными моделями, а некоторые модели работают с 6 ГБ или даже 4 ГБ видеопамяти. А для Apple любой чип M-серии (выпущенный за последние несколько лет) сможет запускать оптимизированные модели.

Программное обеспечение бесплатное, установка занимает несколько минут, и самый пугающий шаг — выбор инструмента для использования — сводится к простому вопросу: вы предпочитаете нажимать кнопки или вводить команды?

LM Studio против Олламы

Две платформы доминируют в местном пространстве ИИ и подходят к проблеме с противоположных сторон.

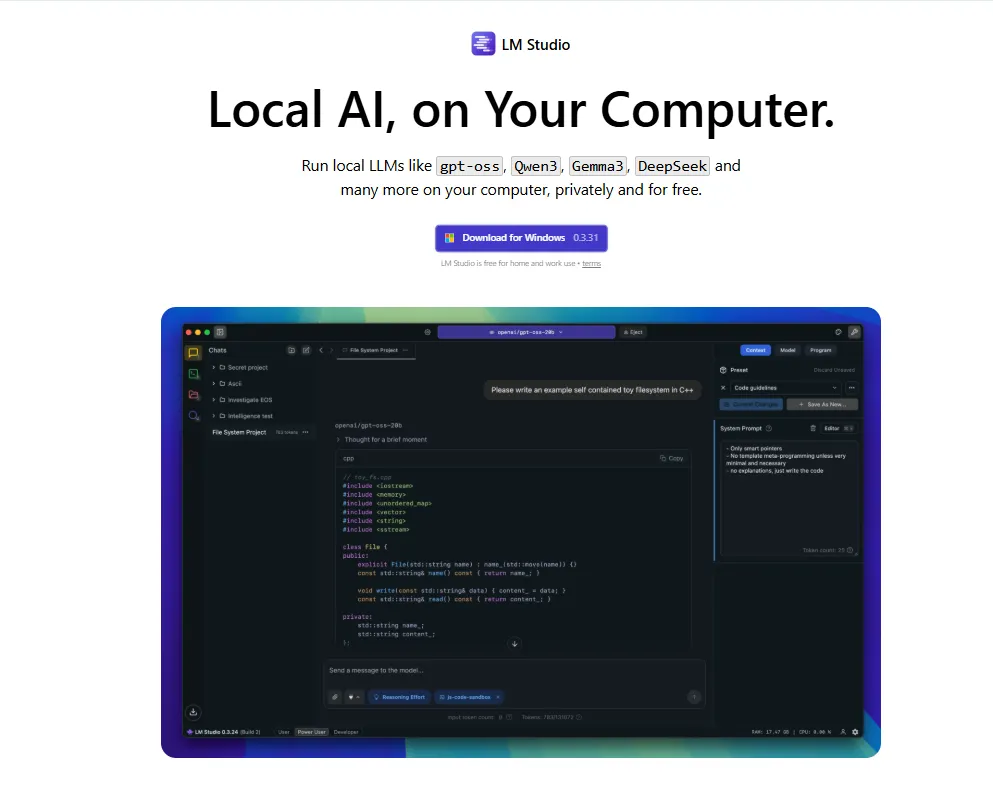

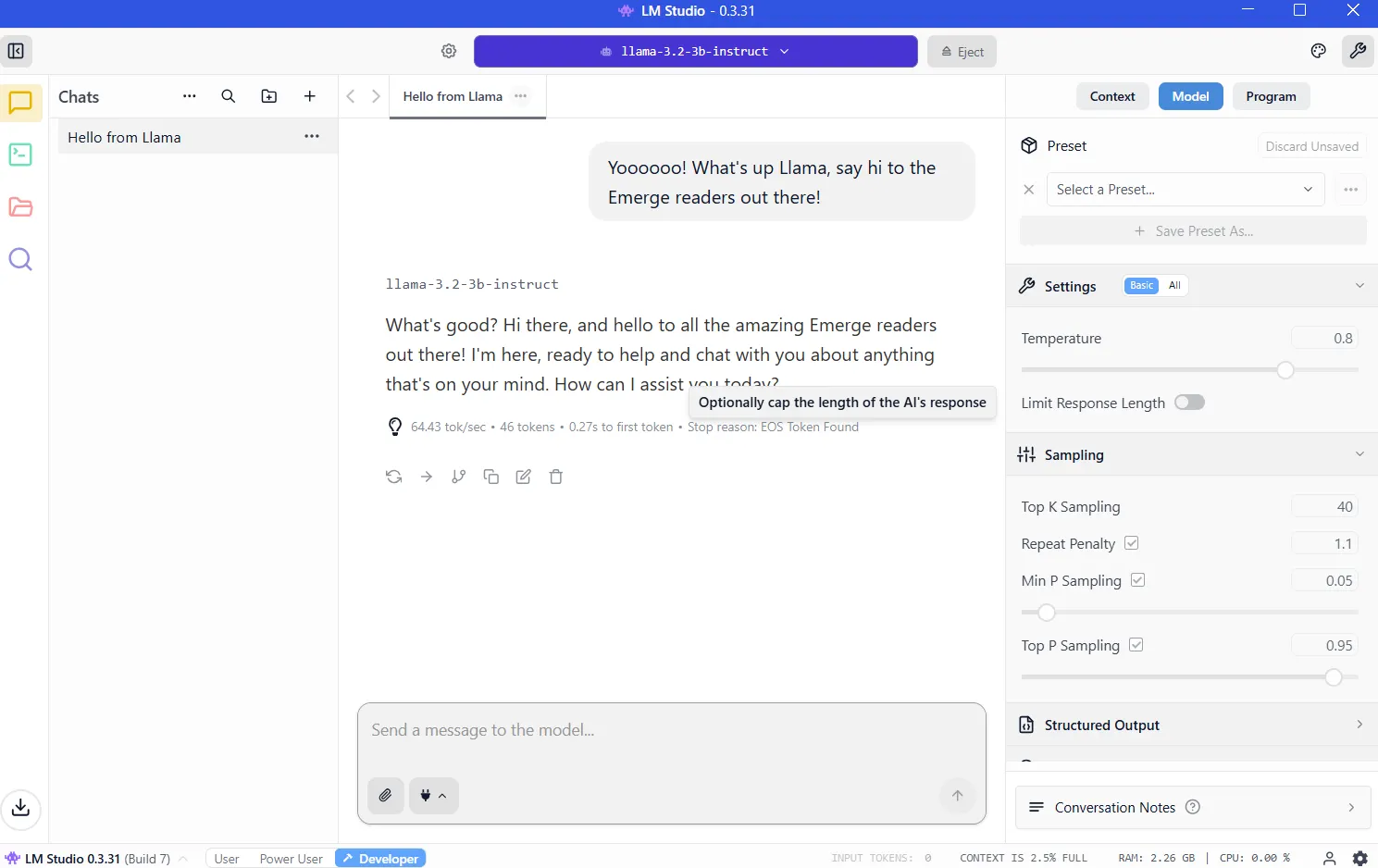

LM Studio объединяет все в безупречный графический интерфейс. Вы можете просто загрузить приложение, просмотреть встроенную библиотеку моделей, нажать кнопку «Установить» и начать общение. Опыт аналогичен использованию ChatGPT, за исключением того, что обработка происходит на вашем оборудовании. Пользователи Windows, Mac и Linux получают одинаковый комфорт. Для новичков это очевидная отправная точка.

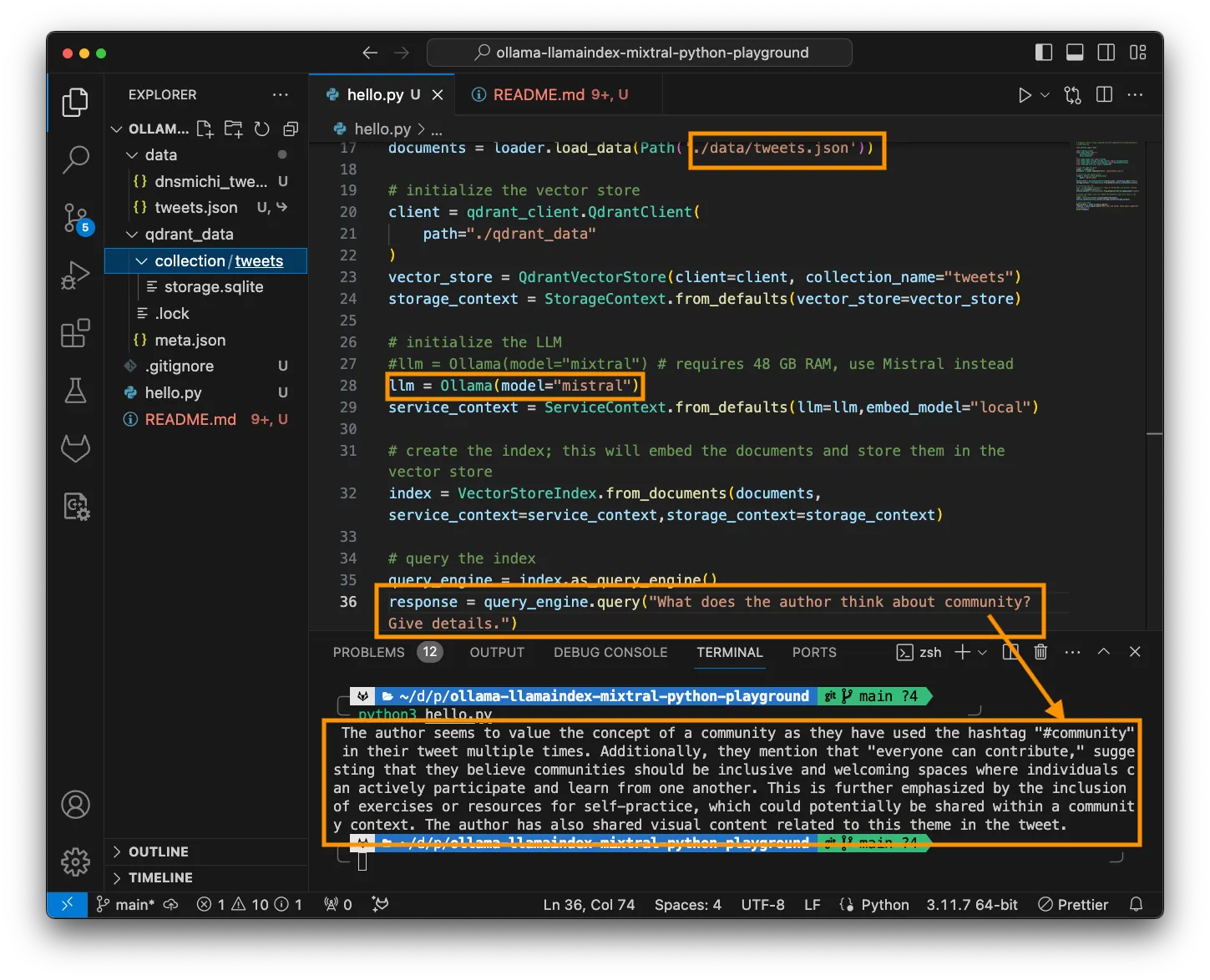

Ollama ориентирована на разработчиков и опытных пользователей, живущих в терминале. Устанавливайте через командную строку, извлекайте модели с помощью одной команды, а затем создайте сценарии или автоматизируйте их по своему усмотрению. Он легкий, быстрый и легко интегрируется в рабочие процессы программирования.

Кривая обучения более крутая, но выгодой является гибкость. Это также то, что опытные пользователи выбирают из-за универсальности и настраиваемости.

Оба инструмента используют одни и те же базовые модели с использованием идентичных механизмов оптимизации. Различия в производительности незначительны.

Настройка LM Studio

Посетите https://lmstudio.ai/ и загрузите установщик для вашей операционной системы. Файл весит около 540МБ. Запустите установщик и следуйте подсказкам. Запустите приложение.

Подсказка 1. Если вас спросят, какой вы тип пользователя, выберите «разработчик». Другие профили просто скрывают опции, чтобы упростить задачу.

Подсказка 2: будет рекомендовано загрузить OSS, модель искусственного интеллекта OpenAI с открытым исходным кодом. Вместо этого нажмите «пропустить»; есть модели получше, меньшего размера, которые справятся со своей задачей лучше.

VRAM: ключ к использованию локального ИИ

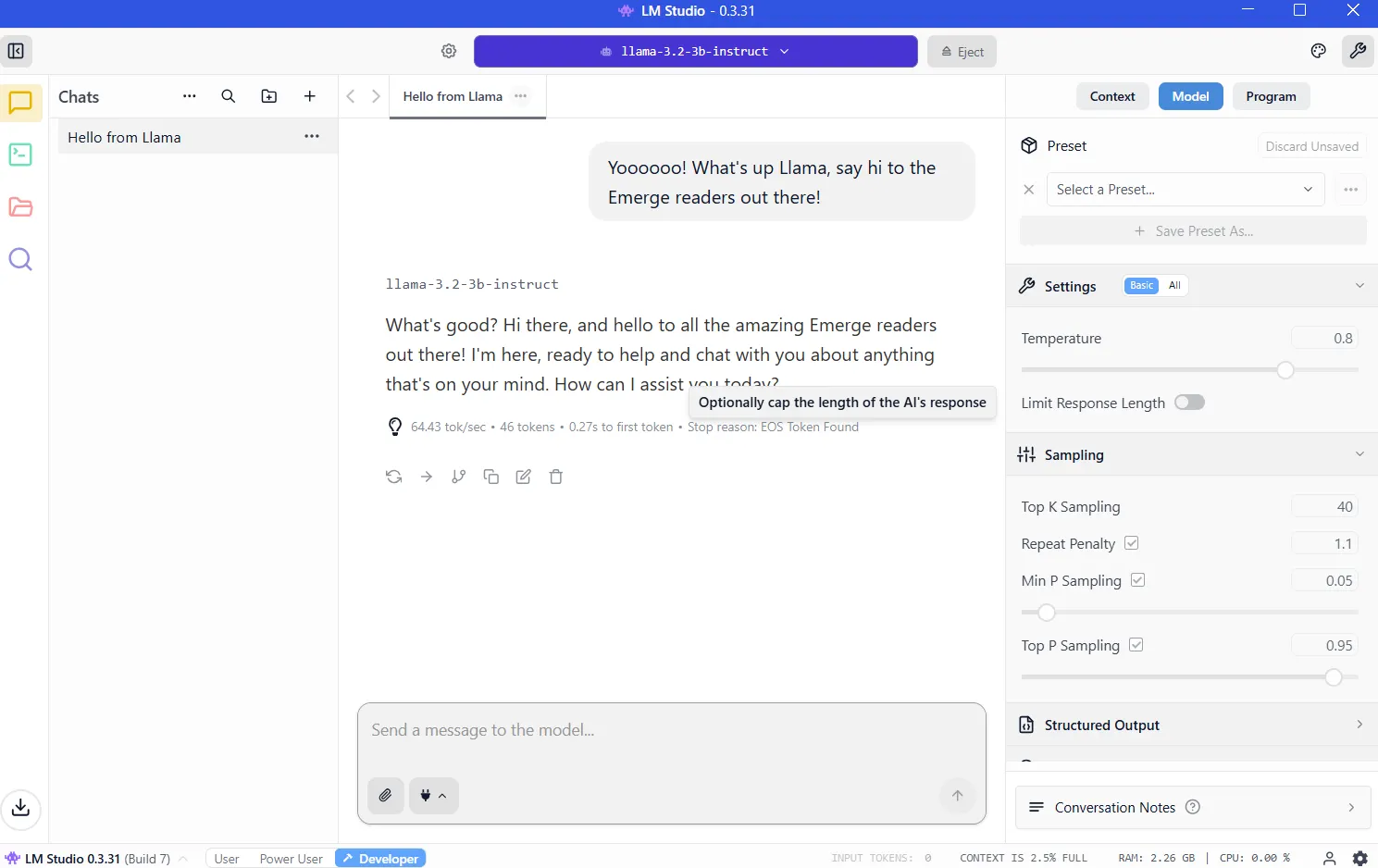

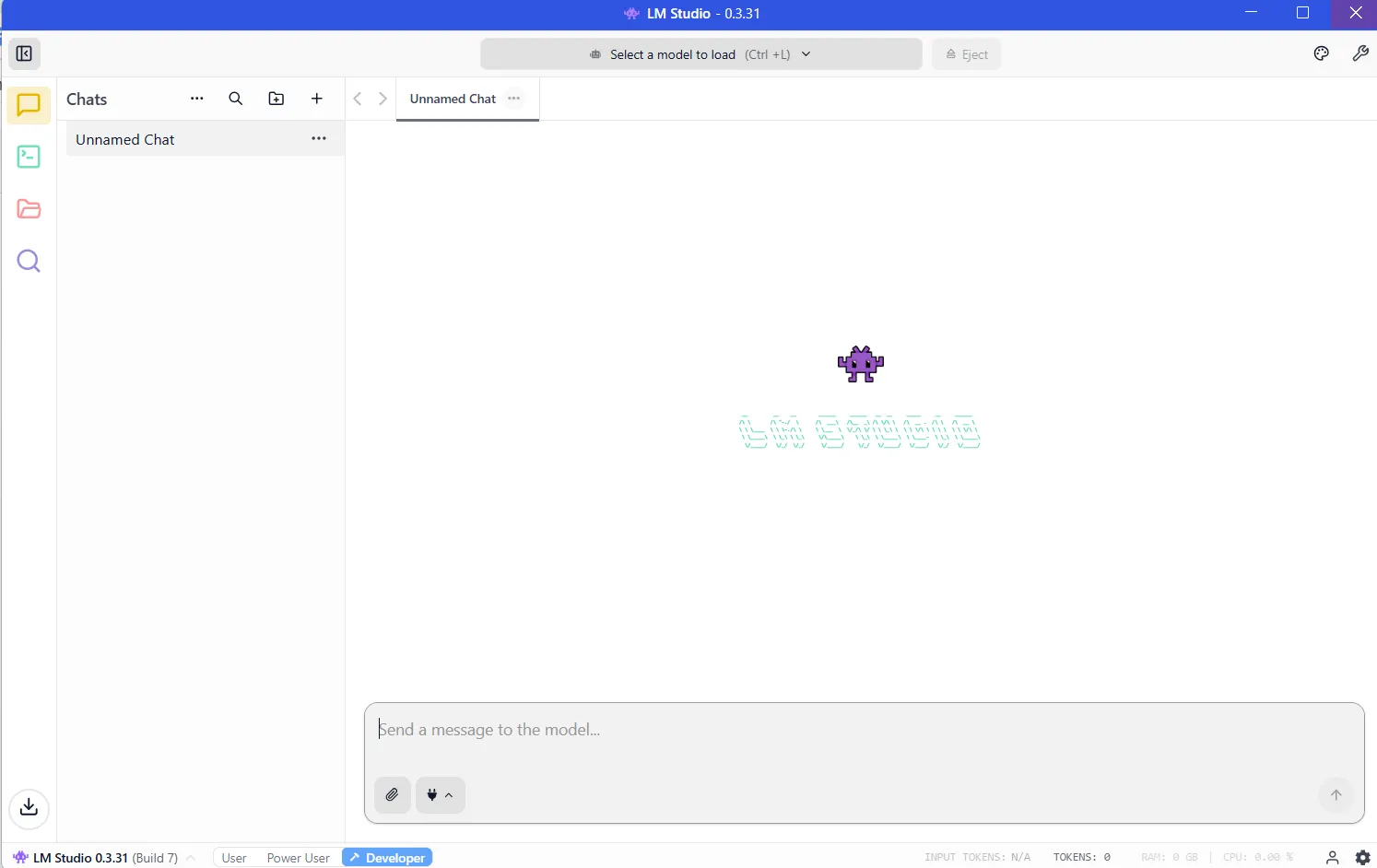

После установки LM Studio программа будет готова к запуску и будет выглядеть следующим образом:

Теперь вам нужно скачать модель, прежде чем ваш LLM заработает. И чем мощнее модель, тем больше ресурсов она потребует.

Важнейшим ресурсом является VRAM или видеопамять вашей видеокарты. LLM загружаются во VRAM во время вывода. Если вам не хватает места, производительность падает, и системе приходится использовать более медленную системную оперативную память. Вам следует избежать этого, имея достаточно видеопамяти для модели, которую вы хотите запустить.

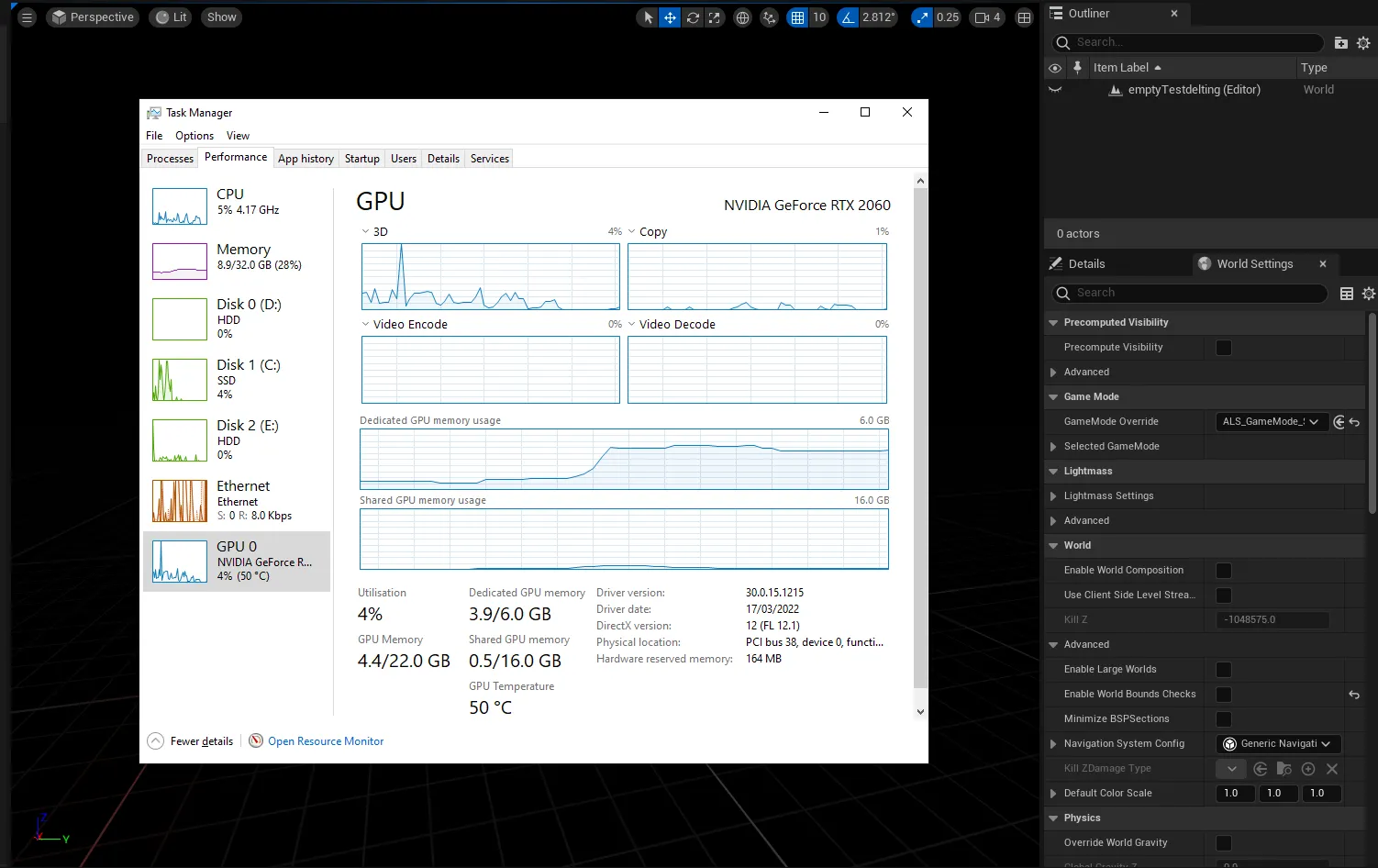

Чтобы узнать, сколько у вас видеопамяти, вы можете войти в диспетчер задач Windows (control+alt+del) и щелкнуть вкладку «Графический процессор», убедившись, что вы выбрали выделенную видеокарту, а не встроенную графику на вашем процессоре Intel/AMD.

Вы увидите, сколько у вас видеопамяти, в разделе «Выделенная память графического процессора».

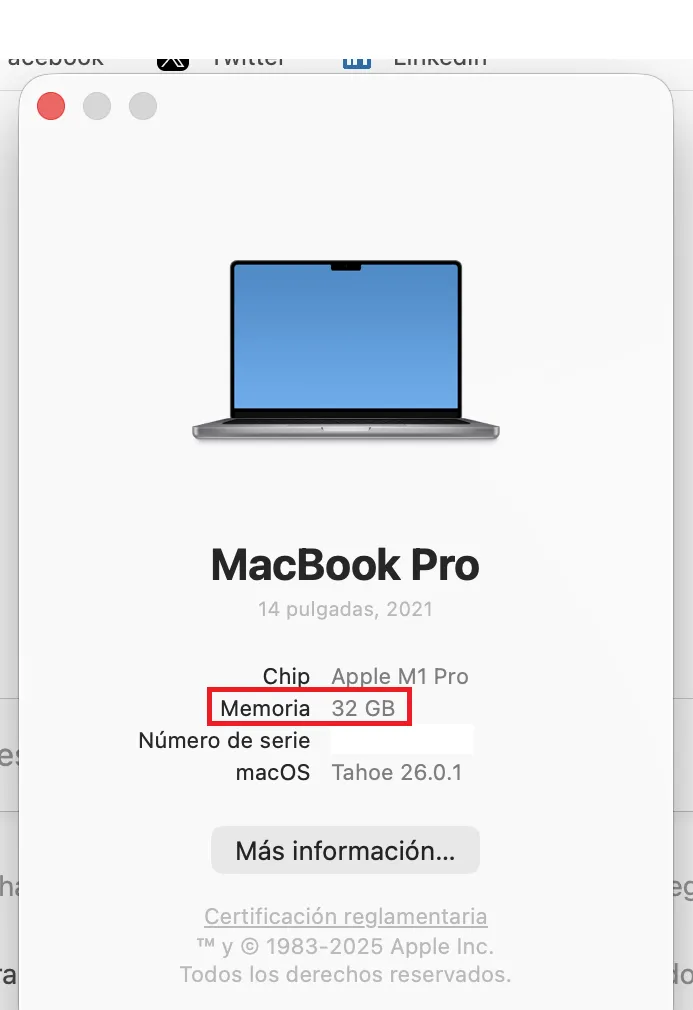

На компьютерах Mac серии M все проще, поскольку они совместно используют ОЗУ и VRAM. Объем оперативной памяти на вашем компьютере будет равен объему видеопамяти, к которому вы можете получить доступ.

Чтобы проверить, нажмите на логотип Apple, затем нажмите «О программе». См. Память? Вот сколько у вас видеопамяти.

Вам понадобится как минимум 8 ГБ видеопамяти. Модели с диапазоном параметров 7–9 миллиардов, сжатые с использованием 4-битного квантования, удобно помещаются и обеспечивают высокую производительность. Вы узнаете, является ли модель квантованной, потому что разработчики обычно указывают это в названии. Если вы видите в названии BF, FP или GGUF, то перед вами квантованная модель. Чем меньше число (FP32, FP16, FP8, FP4), тем меньше ресурсов оно будет потреблять.

Это не яблоки с яблоками, а представьте себе квантование как разрешение вашего экрана. Вы увидите одно и то же изображение в разрешении 8K, 4K, 1080p или 720p. Вы сможете уловить все, независимо от разрешения, но увеличение масштаба и придирчивость к деталям покажет, что изображение 4K содержит больше информации, чем изображение 720p, но для рендеринга потребуется больше памяти и ресурсов.

Но в идеале, если вы настроены серьезно, вам следует купить хороший игровой графический процессор с 24 ГБ видеопамяти. Неважно, новый он или нет, и неважно, насколько он быстрый или мощный. В стране искусственного интеллекта VRAM — король.

Как только вы узнаете, сколько видеопамяти вы можете использовать, вы сможете выяснить, какие модели вы можете использовать, перейдя к калькулятору видеопамяти. Или просто начните с меньших моделей с менее чем 4 миллиардами параметров, а затем переходите к более крупным, пока ваш компьютер не сообщит вам, что у вас недостаточно памяти. (Подробнее об этой технике чуть позже.)

Скачивание ваших моделей

Как только вы узнаете пределы вашего оборудования, пришло время загрузить модель. Нажмите на значок лупы на левой боковой панели и найдите модель по названию.

Qwen и DeepSeek — хорошие модели для начала вашего путешествия. Да, они китайцы, но если вы боитесь, что за вами шпионят, то можете быть спокойны. Когда вы запускаете LLM локально, ничего не покидает вашу машину, поэтому за вами не будут шпионить ни китайцы, ни правительство США, ни какие-либо корпоративные структуры.

Что касается вирусов, все, что мы рекомендуем, поступает через Hugging Face, где программное обеспечение мгновенно проверяется на наличие шпионского и другого вредоносного ПО. Но, как бы то ни было, лучшая американская модель — это «Лама Меты», так что вы можете выбрать ее, если вы патриот. (Другие рекомендации мы предлагаем в последнем разделе.)

Обратите внимание, что модели ведут себя по-разному в зависимости от набора обучающих данных и методов тонкой настройки, использованных для их построения. Несмотря на «Грок» Илона Маска, не существует такого понятия, как беспристрастная модель, потому что не существует такого понятия, как объективная информация. Так что выбирайте яд в зависимости от того, насколько вас волнует геополитика.

На данный момент загрузите версии 3B (меньшая, менее мощная модель) и 7B. Если у вас получается запустить 7В, то удалите 3Б (и попробуйте скачать и запустить версию 13В и т.д.). Если вы не можете запустить версию 7B, удалите ее и используйте версию 3B.

После загрузки загрузите модель из раздела «Мои модели». Появится интерфейс чата. Введите сообщение. Модель отвечает. Поздравляем: вы используете локальный ИИ.

Предоставление вашей модели доступа в Интернет

По умолчанию местные модели не могут просматривать веб-страницы. Они изолированы по своей конструкции, поэтому вы будете работать с ними, основываясь на их внутренних знаниях. Они отлично справятся с написанием коротких рассказов, ответами на вопросы, программированием и т. д. Но они не будут сообщать вам последние новости, сообщать погоду, проверять электронную почту или назначать встречи за вас.

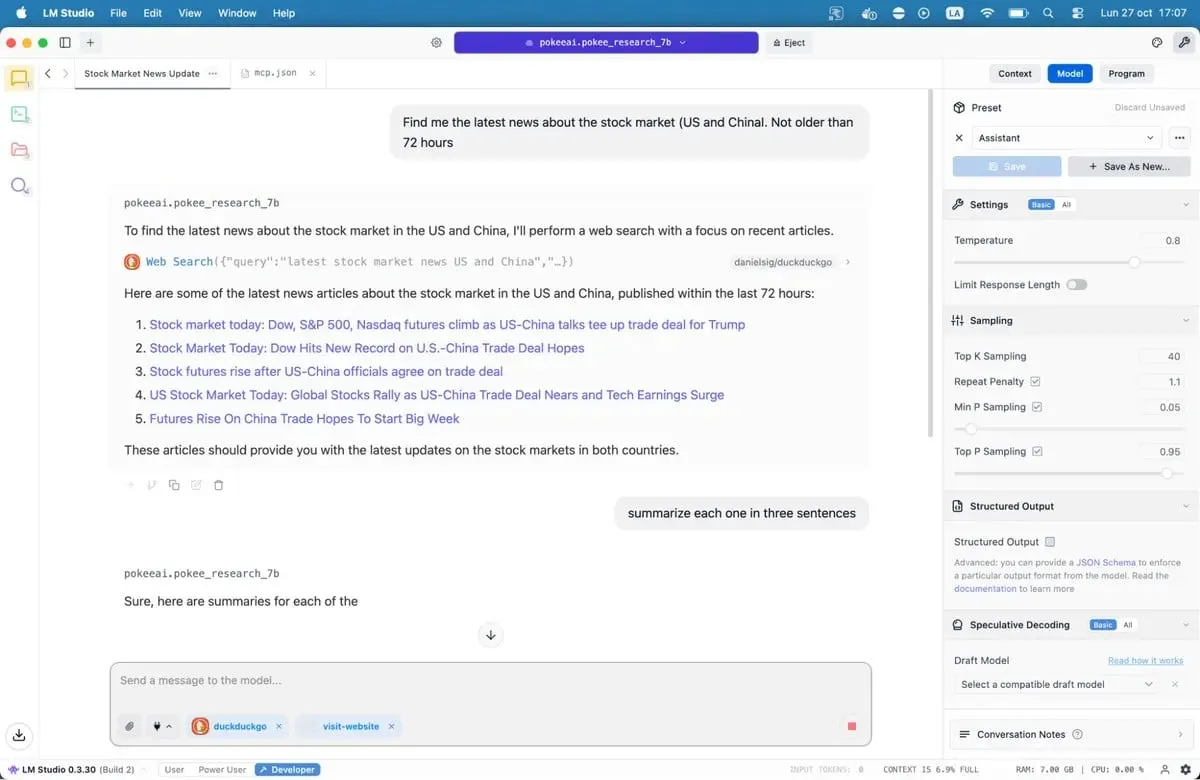

Серверы протокола контекста модели меняют это.

Серверы MCP действуют как мосты между вашей моделью и внешними сервисами. Хотите, чтобы ваш ИИ выполнял поиск в Google, проверял репозитории GitHub или читал веб-сайты? Серверы MCP делают это возможным. В LM Studio добавлена поддержка MCP в версии 0.3.17, доступная через вкладку «Программа». Каждый сервер предоставляет определенные инструменты — веб-поиск, доступ к файлам, вызовы API.

Если вы хотите предоставить моделям доступ к Интернету, в нашем полном руководстве по серверам MCP описан процесс установки, включая такие популярные параметры, как веб-поиск и доступ к базе данных.

Сохраните файл, и LM Studio автоматически загрузит серверы. Когда вы общаетесь со своей моделью, она теперь может вызывать эти инструменты для получения данных в реальном времени. Ваш местный ИИ только что получил сверхспособности.

Наши рекомендуемые модели для систем 8 ГБ

Вам доступны буквально сотни программ LLM: от универсальных вариантов до точно настроенных моделей, предназначенных для специализированных случаев использования, таких как программирование, медицина, ролевые игры или творческое письмо.

Лучше всего для кодирования: Nemotron или DeepSeek. Они не поразят вас, но отлично справятся с генерацией кода и отладкой, превосходя большинство альтернатив в тестах программирования. DeepSeek-Coder-V2 6.7B предлагает еще один надежный вариант, особенно для многоязычной разработки.

Лучше всего для общих знаний и рассуждений: Qwen3 8B. Модель обладает сильными математическими возможностями и эффективно обрабатывает сложные запросы. Его контекстное окно вмещает более длинные документы без потери связности.

Лучше всего подходит для творческого письма: варианты DeepSeek R1, но вам потребуется серьезная быстрая разработка. Существуют также «тонкие настройки» без цензуры, такие как «уничтоженная-без цензуры-NEO-Imatrix» версия OpenAI GPT-OSS, которая хороша для ужасов; или Грязная-Муза-Писательница, которая хороша для эротики (так говорят).

Лучше всего для чат-ботов, ролевых игр, интерактивной фантастики, обслуживания клиентов: Mistral 7B (особенно Undi95 DPO Mistral 7B) и варианты Llama с большими контекстными окнами. MythoMax L2 13B сохраняет черты характера во время долгих разговоров и естественным образом адаптирует тон. Для других ролевых игр NSFW существует множество вариантов. Возможно, вы захотите проверить некоторые модели из этого списка.

Для MCP: Jan-v1-4b и Pokee Research 7b — хорошие модели, если вы хотите попробовать что-то новое. DeepSeek R1 — еще один хороший вариант.

Все модели можно загрузить непосредственно из LM Studio, просто выполнив поиск по их названию.

Обратите внимание, что ландшафт LLM с открытым исходным кодом быстро меняется. Новые модели выпускаются еженедельно, каждая из которых заявляет об улучшениях. Вы можете проверить их в LM Studio или просмотреть различные репозитории на Hugging Face. Проверьте варианты самостоятельно. Плохие совпадения быстро становятся очевидными благодаря неуклюжим формулировкам, повторяющимся шаблонам и фактическим ошибкам. Хорошие модели ощущаются по-другому. Они рассуждают. Они вас удивляют.

Технология работает. Программное обеспечение готово. Вероятно, у вашего компьютера уже достаточно мощности. Остается только попробовать.

Ограничение / снятие ответственности (дисклеймер): Вся информация на этом сайте предоставляется исключительно в информационных целях и не является предложением или рекомендацией к покупке, продаже или удержанию каких-либо ценных бумаг, акций или других финансовых инструментов. Авторы контента не несут ответственности за действия пользователей, основанные на предоставленной информации. Пользователи обязаны самостоятельно оценивать риски и проконсультироваться со специалистами перед принятием каких-либо инвестиционных решений. Вся информация на сайте может быть изменена без предварительного уведомления.

Свежие новости по теме: Криптовалюта, NFT и криптобиржи

-

Криптовалюта и NFT

Биткойн в бычьем слиянии: крест смерти и ключевой сигнал поддержки

2025-12-04 просмотры: 122 -

Криптовалюта и NFT

Эксперт прогнозирует дальнейшее снижение курса биткойнов, поскольку индекс страха и жадности упал до 10

2025-12-04 просмотры: 272 -

Криптовалюта и NFT

Про-биткойн-ресторан Steak 'n Shake объявляет о расширении в Сальвадоре

2025-12-04 просмотры: 271 -

Криптовалюта и NFT

Спекуляции BlackRock XRP ETF растут, поскольку Canary XRPC ETF бьет рекорды

2025-12-04 просмотры: 126 -

Криптовалюта и NFT

Цена биткойна в беде из-за резких скачков продаж на стороне продаж — дальше 92 000 долларов?

2025-12-04 просмотры: 324 -

Криптовалюта и NFT

Председатель SEC представляет криптосистему для отделения ценных бумаг от предметов коллекционирования

2025-12-04 просмотры: 144 -

Криптовалюта и NFT

Ethereum Foundation представляет «Манифест без доверия», призывающий к децентрализации в цепочке

2025-12-04 просмотры: 265 -

Криптовалюта и NFT

Аналитик объясняет, почему не может быть 7 миллионов держателей XRP

2025-12-04 просмотры: 254 -

Криптовалюта и NFT

ETF на криптоиндексы станут следующей волной внедрения — исполнительный директор WisdomTree

2025-12-04 просмотры: 244